개요

DeepSORT 프로젝트에 연계된 Deep Cosine Metric Learning for Person Re-Identification 논문의 얕은 리뷰.

단순 객체 추적 뿐 아니라 사람 재식별 문제는 동일한 사람임을 구별하는 비디오 분야의 Task이다. 이는 일반적으로 메트릭 학습 프레임워크를 통해 해결되며 이는 사람 객체 이미지의 표현 특징을 구분하는 능력을 학습하는 것이다. 이것이 분류 방법으로 해결하지 않는 이유인데, Train 세트에 부여된 ID로 사람에 대한 ID 분류를 학습했다면, Test 세트에 포함된 사람 객체는 ID 분류를 할 수 없기 때문이다. 그래서 위처럼 이러한 이미지의 표현을 학습하고 이를 구분하여 최근접 이웃 쿼리를 수행하여 ID를 구분하는 방법론으로 접근하게 된다.

이는 당시의 Market 1501, MARS 같은 대규모 재식별 데이터 셋의 등장으로 가능하게 되었다. 기존 연구(triplet loss 등)은 메트릭 학습을 같은 클래스 간의 거리는 최소화 하고, 다른 클래스 간의 간격을 넓히는 것으로 요약되는데, 해당 연구에 영감을 받아 본 논문은 메트릭 학습과 분류 방법론의 통합의 방식으로 접근한다.

방법론

- 기존 소프트맥스 함수 및 크로스 엔트로피 손실 함수에 대해 먼저 살펴본다.

- 그리고 코사인 유사도 기반의 소프트맥스 분류기를 재매개화하여 feature representation space에서 코사인 유사도를 학습하도록 설계한다.

- 제안하는 CNN 및 residual block 기반의 아키텍쳐는 다른 SOTA 방법에 비해 경량화 된 구조이다.

- 기존의 삼중 손실(triplet loss)은 복잡한 샘플링 전략이 필요하지만 제안된 방식은 해당 분류기와 크로스 엔트로피 손실만으로 학습이 가능하다.

- 분류(classifier)와 메트릭 학습(metric learning)의 통합으로 네트워크가 처음보는 객체에도 nearest neighbor search 방식을 작동하도록 설계한다.

실험

- 검증 및 실험은 대규모 데이터 셋인 Market 1501 과 MARS 데이터 셋에서 진행한다.

- mAP 및 Rank 1, Rank 5에 대한 성능지표를 비교한다.

- 자석 손실(Magnet Loss)와 코사인기반 소프트맥스(Cosine softmax) 메트릭을 비교하지만 추가로 삼중 손실(Triplet Loss)도 테스트 한다.

- 자석 손실은 최적화 과정에서 샘플링 전략의 차이로 다른 방법들보다 낮은 성능을 보인다.

- 다른 SOTA 방법들이 일부 높은 mAP를 기록했지만 이는 네트워크가 ImageNet 등의 사전학습에 기인한 것으로 보인다.

- 학습 과정에서 삼중 손실을 사용하지 않았지만, 코사인 소프트맥스 분류기가 삼중 손실 값을 간접적으로 감소시키는 것을 확인한다. 이는 기존 삼중 손실이 내포하는 특징 표현 공간의 이미지 유사성 메트릭을 학습했음을 의미한다.

결론

본 논문은 소프트맥스 기반 분류기에 코사인 유사성을 적용한 형태로 재매개화 하여 메트릭 학습과 분류학습을 통합하였고, 이를 사실 DeepSORT의 사람 객체 추적 및 Re-Id 작업에 통합할 수 있도록 제안하였다. 본 논문이 제시한 CNN 기반의 딥러닝 아키텍쳐는 사람의 이미지를 입력으로 받아 코사인 유사도 기반의 분류 및 메트릭을 학습하기에 적절하게 구조화 하였고, 기존 삼중 손실 방법 등에 비해 학습이 간단하고 쉽게 할 수 있는 특징을 가지고 있다. 또한, 온라인 객체 추적을 위해 가벼운 구조로 되어있는 것이 장점이다.

번역

Abstract

메트릭 학습은 동일한 정체성에 해당하는 두 특징이 서로 다른 정체성의 특징보다 더 가깝게 위치할 가능성이 높은 임베딩을 구성하는 것을 목표로 합니다. 본 논문은 기존의 소프트맥스 분류 체계를 간단히 재매개화하여 코사인 유사성을 효과적으로 최적화하는 특징 공간 학습 방법을 제시합니다. 테스트 시에는 코사인 유사성 메트릭을 사용하여 미지의 정체성에 대해 최근접 이웃 쿼리를 수행할 수 있도록 네트워크에서 최종 분류 계층을 제거할 수 있습니다. 이 접근법은 과거에 정교한 쌍 또는 삼중 표본화 전략이 필요했던 시암 네트워크와 같은 직접 메트릭 학습 목표에 대한 간단한 대안을 제공합니다. 이 방법은 대규모 보행자 재식별 데이터셋 두 개를 통해 평가되었으며, 전반적으로 경쟁력 있는 결과를 얻었습니다. 특히, 삼중손실(triplet loss)로 학습된 네트워크에 비해 테스트 세트에서 더 나은 일반화를 달성했습니다.

1. Introduction

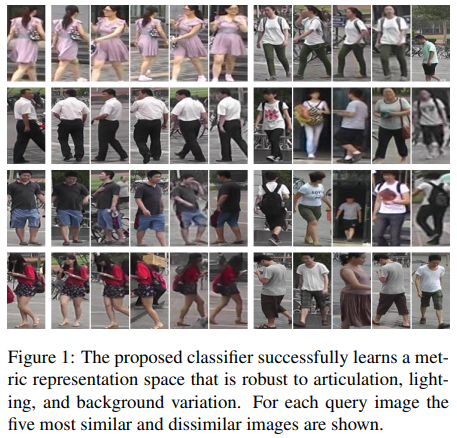

사람 재식별(person re-identification)은 주어진 쿼리 이미지를 사용하여 동일한 사람을 포함할 가능성이 있는 대규모 이미지 갤러리를 검색하는 비디오 감시의 일반적인 작업입니다. 갤러리 이미지는 일반적으로 서로 다른 시간대에 서로 다른 카메라로 촬영되므로 시스템은 자세 변화, 조명 조건의 변화, 그리고 배경의 변화를 처리해야 합니다. 또한 테스트 시 수집된 갤러리에 있는 개별 인물들은 훈련 세트에 포함되지 않으므로 직접적인 정체성 분류는 불가능합니다. 대신, 재식별 문제는 일반적으로 메트릭 학습 프레임워크를 통해 해결됩니다. 여기에서 목표는 테스트 시 제공된 이미지 및 정체성에 대한 최근접 이웃 쿼리를 수행하기에 적합한 특징 표현을 별도의 훈련 정체성 세트로부터 학습하는 것입니다. 이상적으로, 학습된 특징 표현은 앞서 언급한 방해 요인들에 대해 불변성을 가지면서 동시에 특징 유사도가 사람의 정체성에 해당하는 사전 정의된 메트릭을 따라야 합니다.

사람 재식별 데이터셋을 설정하기 위해 필요한 주석 작업으로 인해, 최근까지는 라벨이 지정된 이미지의 양이 제한적이었습니다. 그러나 Market 1501 [36] 및 MARS [35] 데이터셋의 발표로 이러한 상황이 변화했습니다. MARS는 100만 장 이상의 이미지가 반자동으로 주석 처리된 데이터셋입니다. 이 데이터는 다중 대상 추적기를 사용하여 생성되었으며, 신뢰할 수 있는 짧은 궤적 조각들을 추출하고 이를 일관된 객체 궤적으로 주석 처리했습니다. 이러한 주석 절차는 더 많은 데이터를 생성할 뿐만 아니라 데이터셋을 수동 크롭핑이 아닌 사람 검출기를 적용하여 사람을 더 잘 추출할 수 있는 실제 응용 프로그램에 더 가깝게 만듭니다.

다른 비전 과제에서와 마찬가지로, 딥러닝은 더 큰 데이터셋이 등장한 이후로 사람 재식별(person re-identification)의 주요 패러다임이 되었습니다. 하지만 이 문제는 여전히 어려움을 동반하며 완전히 해결되지 않은 상태입니다. 특히, 직접 메트릭 학습 목표와 분류 프레임워크에서 간접적으로 훈련 절차에 접근하는 방법의 성능에 대한 논의가 지속되고 있습니다. 메트릭 학습 목표는 유사도 메트릭을 훈련 목표에 직접적으로 암호화하는 반면, 분류 기반 방법은 훈련 세트의 정체성을 바탕으로 분류기를 훈련한 뒤 네트워크의 기본 특징 표현을 사용하여 테스트 시 최근접 이웃 쿼리를 수행합니다. 한편으로, 과거의 직접 메트릭 학습 목표는 비선형성 또는 이웃 구조에 대한 맥락 정보를 누락하는 등의 바람직하지 않은 속성으로 인해 최적화를 방해하는 경우가 있었습니다 [19]. 다른 한편으로, 이러한 문제는 최근 발표된 연구 [18, 8]에서 성공적으로 접근되었습니다. 그럼에도 불구하고, 유사도가 클래스 멤버십에만 기반을 둔 경우 직접 메트릭 학습이 분류 체제에서의 학습에 비해 명확한 장점을 가지고 있는지는 논란의 여지가 있습니다. 이 환경에서 메트릭 학습은 종종 같은 클래스의 샘플 간의 거리를 최소화하고, 다른 클래스 샘플 간의 간격을 강제하는 것으로 축소됩니다 [3, 8]. 신중히 설정된 분류기는 직접 메트릭 학습 목표와 유사하게 클래스 내 분산을 줄이고 클래스 간 분산을 증가시킬 수 있습니다.

이 논의에 영감을 받아, 본 논문의 주요 기여는 메트릭 학습과 분류의 통합입니다. 구체적으로, 우리는 메트릭 학습 목표를 분류 작업에 직접적으로 암호화하는 소프트맥스 분류기의 간단하면서도 신중한 재매개화를 제시합니다. 마지막으로, 제안된 코사인 소프트맥스 훈련이 테스트 시 미지의 정체성에 대해 학습된 임베딩의 효과를 확장하는 방법을 사람 재식별(context of person re-identification) 문맥에서 입증합니다. 이 방법의 소스 코드는 GitHub 저장소¹에 제공됩니다.

2. Related Work

Metric Learning

합성곱 신경망(CNNs)은 대규모 컴퓨터 비전 문제에서 놀라운 성능을 보여주었으며, 이러한 모델의 하위 표현 공간은 원래의 훈련 목표와 다른 작업에도 성공적으로 전이될 수 있습니다 [5, 22]. 따라서 훈련 샘플이 적은 분류 응용 프로그램에서는 ImageNet [11] 또는 MS COCO [16]에서 미리 학습된 일반적인 목적의 특징 표현을 기반으로 작업별 분류기를 훈련하는 경우가 종종 있습니다. 그러나 소프트맥스 분류기로 학습된 네트워크의 표현이 사람 재식별과 같은 이미지 검색 작업에서 직접 사용될 수 있다는 보장은 없습니다. 이는 이러한 표현이 최근접 이웃 쿼리에 사용될 수 있는 특정(알려진) 메트릭을 반드시 따르지 않기 때문입니다. 그럼에도 불구하고 얼굴 인증과 사람 재식별에서 성공적으로 응용된 사례들이 존재합니다 [24, 31, 37]. 이 경우, 소프트맥스 분류기는 훈련 세트에서 정체성을 구별하도록 학습됩니다. 훈련이 완료되면 네트워크에서 분류기를 제거하고 네트워크의 마지막 계층에서 코사인 유사성 또는 유클리드 거리를 사용하여 거리 쿼리를 수행합니다. 그러나, 만약 표현이 직접 사용될 수 없다면, 후처리 단계에서 메트릭 하위 공간을 찾는 것이 대안이 될 수 있습니다 [10, 15].

딥 메트릭 학습 접근법은 유사성 개념을 훈련 목표에 직접적으로 인코딩합니다. 가장 대표적인 공식은 대조 손실 [3] 및 삼중 손실 [28]을 사용한 시암 네트워크입니다. 대조 손실은 같은 클래스 샘플 간의 거리를 최소화하고 다른 클래스 샘플 간에 여유 공간을 강제합니다. 실질적으로 이 손실은 표현 공간에서 동일 클래스의 모든 샘플을 단일 지점으로 밀어내며, 다른 클래스 간의 중복을 처벌합니다. 삼중 손실은 대조 손실 공식을 완화하여, 여유 공간이 유지되는 한 샘플이 더 자유롭게 이동할 수 있도록 허용합니다. 기준 점(anchor point), 동일 클래스의 점, 그리고 다른 클래스의 점을 주어진 상태에서, 삼중 손실은 동일 클래스 점까지의 거리가 다른 클래스 점까지의 거리보다 작도록 강제합니다.

대조 손실(contrastive loss)과 삼중 손실(triplet loss)은 메트릭 학습 문제(e.g., [21, 26, 8])에 성공적으로 적용되었지만, 성공 여부는 주로 효율적인 쌍/삼중 표본 추출 전략에 의존해왔습니다. 주어진 데이터셋에서 생성할 수 있는 많은 쌍과 삼중 항목들은 신원을 구별하는 데 필요한 관련 구조에 대해 거의 정보를 제공하지 않을 수 있습니다. 만약 구별하기 어려운 쌍/삼중 항목이 각 배치에 잘못 포함되면, 옵티마이저가 의미 있는 학습에 실패하거나 전혀 수렴하지 않을 수 있습니다. 효과적인 샘플링 전략의 개발은 복잡하고 시간이 많이 걸리는 작업일 수 있으며, 이로 인해 시암 네트워크의 실질적인 적용 가능성이 제한됩니다.

대조 손실과 삼중 손실과 관련된 두 번째 문제는 서로 다른 클래스 샘플 간에 적용되는 고정 여유(hard margin)에서 발생합니다. 고정 여유는 비선형 목적 함수를 유발하여 최적화가 더 어려워지는데, 이는 각 반복에서 옵티마이저에 제공되는 샘플 수가 적고 배치 간 강한 의견 불일치가 있을 수 있기 때문입니다 [19]. 이러한 문제는 최근에 해결되었습니다. 예를 들어, Song et al. [18]은 GPU에서 각 배치에서 유익한 샘플을 직접 추출하여 구현할 수 있는 기존 삼중 손실 공식의 매끄러운 상한선을 제안했습니다. 고정 여유가 소프트 여유로 대체된 삼중 손실의 유사한 공식은 사람 재식별 문제에서 우수한 성능을 보였습니다 [8].

시암 네트워크 공식 외에도, 자석 손실(magnet loss) [19]은 많은 관련 문제를 극복하기 위한 대안으로 제안되었습니다. 이 손실은 올바른 클래스와 다른 모든 클래스 간의 음의 로그 우도 비율로 공식화되며, 다른 클래스 샘플 간에도 여유를 강제합니다. 개별 쌍이나 삼중 항목 대신 전체 클래스 분포를 기반으로 작동함으로써 자석 손실은 잠재적으로 더 빠르게 수렴하고 전반적으로 더 나은 솔루션을 제공합니다. 중심 손실(center loss) [29]은 분류와 메트릭 학습을 결합하려는 시도로 개발되었습니다. 이 공식은 소프트맥스 분류기와 샘플을 클래스 평균에 가까이 배치하여 컴팩트한 클래스를 강제하는 추가 항을 결합한 형태를 사용합니다. 스칼라 하이퍼파라미터는 두 손실 간의 균형을 맞춥니다. 실험에 따르면 이 분류와 메트릭 학습의 결합 공식이 최첨단 결과를 산출한다고 제안됩니다.

Person Re-Identification

더 큰 데이터셋이 등장함에 따라, 사람 재식별은 딥 메트릭 학습의 응용 분야가 되었으며, 이 작업을 위해 설계된 여러 CNN 아키텍처가 개발되었습니다. 이들 대부분은 중간 수준의 특징(mid-level features)에 중점을 두고, 아키텍처에 특수한 유닛을 도입하여 자세 변화와 관점 변화에 명시적으로 대응하려고 합니다. 예를 들어, Li et al. [13]은 중간 수준 특징 간의 변위를 캡처하는 특수 패치 매칭 레이어를 갖춘 CNN을 제안했습니다. Ahmed et al. [1]은 두 입력 이미지의 특징 맵에서 이웃 간의 차이를 계산하는 특수 컨볼루션을 적용하여 유사하게 특징 변위를 캡처합니다. Varior et al. [26]의 네트워크에서 게이팅 함수는 가로 줄무늬를 따라 특징을 비교하고, 로컬 패턴에 얼마나 주목해야 하는지를 나타내는 게이팅 마스크를 출력합니다. 마지막으로, [27]에서는 이미지를 행 단위로 처리하는 반복적(recurrent) 시암 신경망 아키텍처를 제안했습니다. 반복적 아키텍처의 아이디어는 순차적 처리를 통해 맥락 정보를 증가시키는 것입니다.

사람 재식별에 관한 최근 연구는 기본 CNN 아키텍처가 특화된 대안과 경쟁할 수 있음을 시사합니다. 특히, MARS [35]에서 현재 최고의 성능을 보이는 방법은 기존의 잔차 네트워크(residual network)입니다 [8]. 기본 CNN 아키텍처를 적용하는 것은 사전 학습된 모델을 이용해 사람 재식별 작업에 맞춰 미세 조정할 수 있을 경우 유익할 수 있습니다. 사전 학습이 전체 성능에 미치는 영향은 [35]에서 연구되었습니다. 보고에 따르면, 사전 학습을 통해 9.5%에서 10.2%의 인식률이 향상된다고 합니다 [11].

3. Standard Softmax Classifier

$N$ 개의 학습 이미지 $x_i∈\mathbb{R}^D$ 와 연관된 클래스 레이블 $y_i∈\lbrace 1,…,C\rbrace$ 로 구성된 데이터셋 $\mathcal{D}=\lbrace(x_i,y_i)\rbrace_{i=1}^N$ 이 주어질 때, 딥러닝 설정에서 분류의 표준 접근법은 입력 이미지를 CNN으로 처리하고 네트워크 상단에 소프트맥스 분류기를 배치하여 $C$개의 클래스 각각에 대한 확률 점수를 얻는 것입니다. 소프트맥스 분류기는 다음 매개 함수에 따라 최대 확률을 가진 클래스를 선택합니다.

\[\begin{equation} p(y=k|r) = \frac{\exp{({w_k}^Tr+b_k)}}{\sum^C_{n=1}\exp{({w_n}^Tr+b_n)}} \tag{1} \end{equation}\]여기서 $r=f(x),r∈\mathbb{R}^d$ 는 분류기와 함께 학습되는 매개화된 인코더 네트워크의 기본 특징 표현입니다. $C=2$ 클래스의 특수한 경우, 이 공식은 로지스틱 회귀와 동일합니다. 또한, 특정 함수 형태의 선택은 분류 문제에 대한 생성적 관점에서 동기부여될 수 있습니다. 클래스 조건부 밀도가 Gaussian이라면

\[\begin{align} & p(r|y=k) = \\ & \frac{1}{\sqrt{|2\pi\Sigma|}}\exp{\left(-\frac{1}{2}(r-\mu_k)^T\Sigma^{-1}(r-\mu_k)\right)} \tag{2} \end{align}\]공통 공분산 $Σ$ 를 가지는 경우, 후행 클래스 확률은 베이즈 규칙에 의해 계산될 수 있습니다.

\[\begin{align} p(y=k|r) &= \frac{p(r|y=k)p(y=k)}{\sum_{n=1}^Cp(r|y=n)p(y=n)} \tag{3} \\ &= \frac{\exp{(w_k^Tr+b_k)}}{\sum_{n=1}^C\exp{(w_n^Tr+b_n)}} \tag{4} \end{align}\]여기서 $w_k=Σ^{−1}μ_k$ , $b_k=−\frac{1}{2}μ_k^⊤Σ^{−1}μ_k+\log{p}(y_i=k)$ [2]. 그러나 소프트맥스 분류기는 차별적 체제에서 학습됩니다. 클래스 조건부 밀도 및 사전 클래스 확률의 매개변수를 결정하는 대신, 조건부 클래스 확률의 매개변수 $\lbrace w_1,b_1,…,w_C,b_C\rbrace$ 는 분류 손실을 최소화함으로써 직접적으로 얻어집니다. $\mathbb{1}_{y=k}$ 를 $y$ 가 $k$ 와 같으면 1로 평가하고, 그렇지 않으면 0으로 평가하는 지시자 함수라고 합시다. 그러면, 해당 손실은 다음과 같습니다.

\[\mathcal{L}(\mathcal{D}) = -\sum_{i=1}^N\sum_{k=1}^C\mathbb{1}_{y_i=k}\cdot\log{p(y_i=k|r_i)} \tag{5}\]이 손실은 소프트맥스 분류기 $p(y=k∣r)$ 의 추정 확률과 실제 레이블 분포 $p(y=k)=\mathbb{1}_{y=k}$ 간의 교차 엔트로피를 최소화합니다. 교차 엔트로피 손실을 최소화함으로써, 매개변수는 올바른 클래스의 경우 1에 가깝고 나머지 클래스의 경우 0에 가까운 추정 확률을 가지도록 선택됩니다.

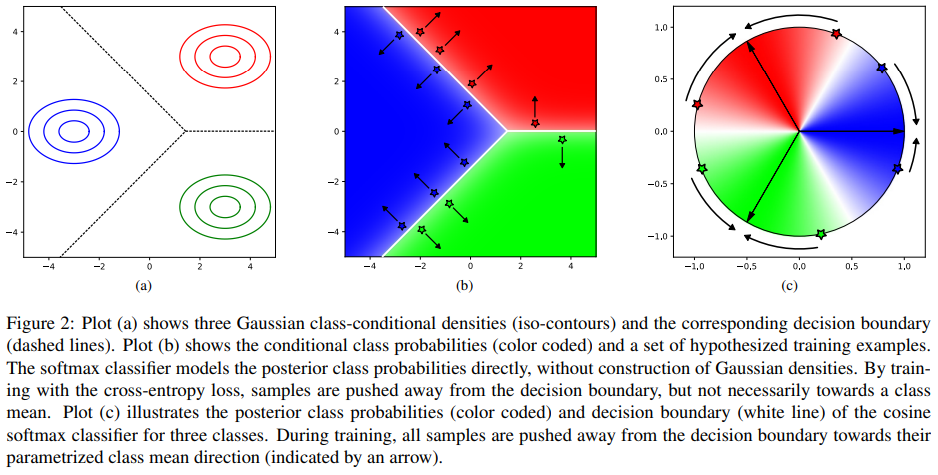

그림 2a는 세 개의 가우시안 밀도 $p(r∣y)$ 와 해당 결정 경계를 보여줍니다. 이 시나리오의 후행 클래스 확률은 그림 2b에 가정된 학습 샘플 세트와 함께 표시됩니다. 가우시안 밀도가 클래스 평균 주변에서 최고조에 달하는 반면, 후행 클래스 확률은 결정 경계까지의 거리의 함수로 나타납니다. 특징 인코더가 교차 엔트로피 손실을 최소화하면서 분류기와 함께 학습될 때, 인코더 네트워크의 매개변수는 샘플을 결정 경계에서 최대한 멀리 밀어내도록 조정되지만, 반드시 특정 함수 형태를 동기부여했던 클래스 평균으로 밀어내는 것은 아닙니다. 이러한 행동은 메트릭 학습에서 문제가 됩니다. 왜냐하면 클래스 멤버십의 유사성이 특징 표현 자체가 아니라 결정 경계의 방향에 암호화되기 때문입니다.

4. Cosine Softmax Classifier

몇 가지 수정으로 표준 소프트맥스 분류기를 표현 공간에서 컴팩트한 클러스터를 생성하도록 변경할 수 있습니다. 첫째, $ℓ_2$ 정규화를 인코더 네트워크의 마지막 계층에 적용하여 표현이 단위 길이 $∥f_Θ(x)∥_2=1,∀x∈\mathbb{R}^D$ 를 갖도록 해야 합니다. 둘째, 가중치도 단위 길이로 정규화되어야 합니다. 즉, $\tilde{w}_k=w_k/∥w_k∥_2,∀k=1,…,C$ 입니다. 그런 다음, 코사인 소프트맥스 분류기는 다음과 같이 정의될 수 있습니다.

\[p(y=k|r)=\frac{\exp{(\kappa \cdot \tilde{w}^T_kr )}}{\sum_{n=1}^C\exp{(\kappa\cdot\tilde{w}^T_nr)}} \tag{6}\]여기서 $κ$ 는 자유 스케일링 매개변수입니다. 이 매개화는 $b_k$ 편향 항이 제거되었기 때문에 표준 공식(1)에 비해 $C−1$ 개의 매개변수가 적습니다 $\lbrace κ, \tilde{w}_1,…, \tilde{w}_C\rbrace$. 그렇지 않으면, 기능적 형태는 표준 매개화와 강한 유사성을 가지며 구현이 간단합니다. 특히, 가중치 벡터 $κ$ 의 크기를 방향과 분리하는 것은 확률적 경사 하강법의 수렴을 가속화하는 방법으로 제안되었습니다 [20]. 훈련 자체는 표준 공식에 비해 매개화의 변경일 뿐이므로 일반적으로 교차 엔트로피 손실을 사용하여 수행될 수 있습니다.

로그 확률의 기능적 모델링은 $κ⋅\tilde{w}_k^⊤r$ 로 표현되며 생성적 관점에서 동기부여될 수 있습니다. 클래스 조건부 가능도가 폰 미세스-피셔(von Mises-Fisher, vMF) 분포를 따르는 경우

공통 집중 매개변수 $κ$ 와 정규화 항 $c_d(κ)$ 를 가진다면, 방정식 6은 동일한 사전 가정 $p(y=k)=p(y=l),∀k,l∈\lbrace 1,…,C\rbrace$ 하의 후행 클래스 확률입니다. vMF 분포는 $\mathbb{R}_d$ 의 $d−1$ 차원 구면 상의 등방성 확률 분포로, 평균 방향 $\tilde{w}_k$ 를 중심으로 최고조에 달하며 코사인 유사도가 감소함에 따라 감소합니다.

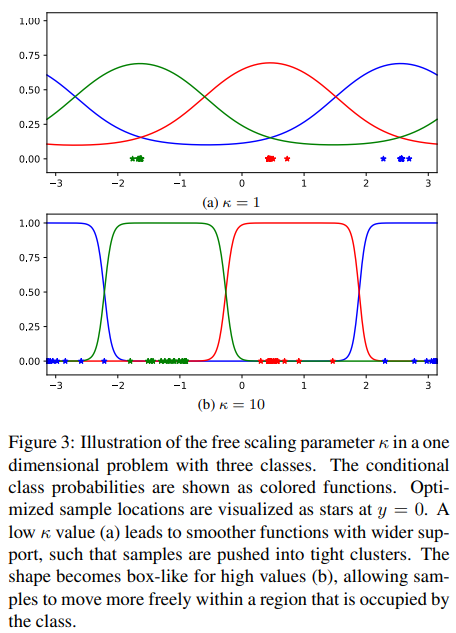

이 매개화가 표현 공간에서 코사인 유사성을 적용하는 이유를 이해하려면, 로그 확률이 훈련 샘플과 매개화된 클래스 평균 방향 간의 코사인 유사성에 직접 비례한다는 점을 관찰해야 합니다. 교차 엔트로피 손실을 최소화함으로써, 샘플은 결정 경계에서 매개화된 평균 방향으로 밀려나며, 이는 그림 2c에 나타나 있습니다. 결과적으로 매개변수 벡터 $\tilde{w}_k$ 는 $k$ 케이스의 모든 샘플을 대변하게 됩니다. 스케일링 매개변수 $κ$ 는 그림 3에서 보여지듯 조건부 클래스 확률의 형태를 제어합니다. 낮은 $κ$ 값은 더 부드럽고 넓은 지원 범위를 가진 함수에 해당합니다. 높은 $κ$ 값은 결정 경계 주변에서 박스형 조건부 클래스 확률을 생성합니다. 이는 오분류된 샘플에 더 큰 패널티를 부여하지만, 동시에 샘플이 해당 클래스가 차지하는 표현 공간 내에서 더 자유롭게 이동할 수 있도록 합니다. 이와 같은 맥락에서, 스케일은 직접 메트릭 학습 목표에서 여유 매개변수와 유사한 역할을 수행합니다. 스케일이 자유 매개변수로 남아 있을 때, 옵티마이저는 클래스 간 중첩이 감소함에 따라 그 값을 점진적으로 증가시킵니다. 서로 다른 클래스 샘플 간의 여유는 가중치 감소로 스케일을 정규화하여 적용할 수 있습니다.

5. Evaluation

평가의 첫 번째 부분은 처음부터 학습된 네트워크를 사용하여, 제안된 손실 공식과 일반적인 메트릭 학습 손실 간의 학습 행동 및 검증 오류를 비교합니다. 두 번째 부분에서는 동일한 데이터셋에서 기존 재식별 시스템과 전체 시스템 성능을 비교합니다.

5.1. Network Architecture

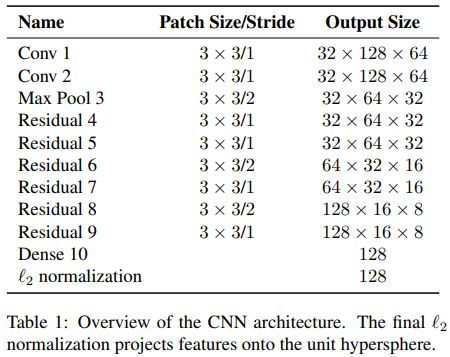

본 실험에서 사용된 네트워크 아키텍처는 빠른 학습과 추론을 가능하게 하기 위해 비교적 얕습니다. 이는 외형 기반 객체 추적과 같은 관련 작업에 응용하기 위함입니다 [30]. 아키텍처는 표 1에 요약되어 있습니다. 입력 이미지는 $

128×64$ 로 재조정되고 RGB 색 공간으로 네트워크에 제공됩니다. 일련의 합성곱 계층은 특징 맵의 크기를 $16×8$ 로 줄이고, 이후 Dense 10 계층에서 길이 128의 전역 특징 벡터를 추출합니다. 최종 $ℓ_2$ 정규화는 코사인 소프트맥스 분류기를 적용하기 위해 특징을 단위 초구면(unit hypersphere)으로 투영합니다. 네트워크는 He et al. [7]이 제안한 사전 활성화(pre-activation) 레이아웃을 따르는 여러 잔차(residual) 블록을 포함합니다. 디자인은 넓은 잔차 네트워크 [33]의 아이디어를 따릅니다: 모든 합성곱은 $3×3$ 크기이며, 최대 풀링(max pooling)은 스트라이드 2의 합성곱으로 대체됩니다. 특징 맵의 공간 해상도가 줄어들면, 병목 현상을 방지하기 위해 채널 수가 적절히 증가합니다. 드롭아웃과 배치 정규화는 정규화 수단으로 사용되며, 모든 계층에서 지수적 선형 단위(Exponential Linear Units, ELU) [4]가 활성화 함수로 사용됩니다.

총 15개의 계층(각 잔차 블록에 두 개의 합성곱 계층 포함)을 가진 네트워크는 현재의 깊은 아키텍처 추세에 비해 상대적으로 얕습니다 [7]. 이 결정은 다음 두 가지 이유에서 이루어졌습니다. 첫째, 네트워크 아키텍처는 사람 재식별과 온라인 사람 추적 모두에 응용될 수 있도록 설계되었습니다 [30]. 후자는 외형 특징의 빠른 계산을 필요로 합니다. 전체적으로 네트워크는 2,800,864개의 매개변수를 가지며, 32개의 바운딩 박스에 대한 단일 전방 패스(forward pass)는 Nvidia GeForce GTX 1050 모바일 GPU에서 약 30ms가 소요됩니다. 따라서, 이 네트워크는 저가 하드웨어에서도 온라인 추적에 적합합니다. 둘째, 사람 재식별을 위해 특별히 설계된 아키텍처는 중간 수준 특징에 특별히 중점을 둡니다 [13, 1]. 따라서, 밀집 계층은 특징 맵이 여전히 충분한 공간 해상도를 제공하는 지점에 추가됩니다.

5.2. Datasets and Evaluation Protocols

평가는 Market 1501 [36]과 MARS [35] 데이터셋에서 수행됩니다. Market 1501은 1,501개의 정체성과 약 30,000개의 이미지를 포함하며, 이는 6개의 카메라에서 촬영되었습니다. MARS는 Market 1501의 확장판으로, 1,261개의 정체성과 1,100,000개 이상의 이미지를 포함합니다. 이 데이터는 다중 대상 추적기(multi-target tracker)를 사용하여 생성되었으며, 이는 짧은 궤적 조각(tracklets)을 생성하고 이를 수작업으로 일관된 정체성에 주석을 달았습니다. 두 데이터셋 모두 상당한 경계 상자 정렬 오류 및 라벨링 부정확성을 포함합니다. 모든 실험에서 단일 쿼리 이미지가 다른 카메라에서 촬영된 갤러리 이미지와 매칭되는 단일 샷(single-shot), 교차 뷰(cross-view) 평가 프로토콜이 채택되었습니다. 갤러리 이미지의 순위는 적절한 경우 코사인 유사성 또는 유클리드 거리를 사용하여 설정됩니다. 학습 및 테스트 데이터 분할은 저자들에 의해 제공됩니다. 추가적으로, 학습 데이터의 10%는 하이퍼파라미터 튜닝 및 조기 중단(early stopping)을 위해 분할됩니다. 두 데이터셋 모두에서 누적 매칭 특성(CMC) 랭크 1 및 5와 평균 평균 정밀도(mAP)가 보고됩니다. 점수는 해당 데이터셋 저자들이 제공한 평가 소프트웨어로 계산됩니다.

5.3. Baseline Methods

전체 성능에 대한 분류와 메트릭 학습 프레임워크의 성능을 평가하기 위해, 네트워크 아키텍처는 두 가지 기준 직접 메트릭 학습 목표를 사용하여 반복적으로 학습됩니다.

Triplet loss

삼중 손실 [28]은 세 개의 예제 $r_a, r_p$, 및 $r_n$ 에 대해 정의되며, 이 중 하나는 양의 쌍 $y_a=y_p$ 과 음의 쌍 $y_a \neq y_n$ 을 포함합니다. 각 삼중 항목에 대해 손실은 음의 쌍과 양의 쌍 간의 거리가 사전 정의된 여유 $m∈\mathbb{R}$ 보다 커야 한다고 요구합니다:

\[\mathcal{L}_t(r_a, r_p,r_n)=\lbrace \Vert r_a-r_n\Vert_2 -\Vert r_a-r_p\Vert_2 +m \rbrace_+, \tag{8}\]여기서 $\lbrace\rbrace_+$ 는 음수 값에 대해 0으로 평가되고, 그렇지 않으면 동일성을 반환하는 힌지 함수입니다. 본 실험에서는 원래 삼중 손실 [8]의 소프트 여유 버전이 사용되며, 이 경우 힌지가 부드러운 플러스 함수 $\lbrace x+m \rbrace_+ =\log(1+exp(x))$로 대체되어 비선형성 문제를 방지합니다 [19]. 또한, 삼중 항목은 [8]에서 제안한 대로 GPU에서 직접 생성되어 샘플링 전략에서 발생할 수 있는 잠재적 문제를 방지합니다. 이 특정 삼중 손실 구현은 현재 MARS 데이터셋에서 가장 성능이 우수한 모델을 학습하는 데 사용되었습니다.

Magnet loss

자석 손실은 개별 샘플이 아닌 전체 클래스 분포를 다루는 시암 손실 공식을 대안으로 제안되었습니다. 이 손실은 각 샘플이 다른 클래스 평균에서 떨어진 거리에 따라 분리를 강제하는 가능도 비율 측정값입니다. 원래의 제안 [19]에서 이 손실은 다중 모드 형식을 취합니다. 여기에서는 단일 샷(person re-identification) 작업에 더 적합하도록 단일 모드(unimodal) 변형이 사용됩니다:

\[\mathcal{L}_m(y,r) = \left\lbrace -\log{\frac{e^{-\frac{1}{2\hat{\sigma}^2}\Vert r-\hat{\mu}_y\Vert^2_2-m}}{\sum_{k\in\bar{\mathcal{C}}(y)}e^{-\frac{1}{2\hat{e}^2}\Vert r-\hat{\mu}_k\Vert_2^2}}} \right\rbrace_+, \tag{9}\]여기서 $\bar{\mathcal{C}}(y)=\lbrace 1,…,C \rbrace ∖ \lbrace y \rbrace$, $m$ 은 다시 여유 매개변수이고, $μ_y$ 는 클래스 $y$ 의 샘플 평균, $σ_2$ 는 클래스 평균에서 벗어난 모든 샘플의 분산입니다. 이러한 매개변수는 각 배치마다 GPU에서 개별적으로 계산됩니다.

5.4. Results

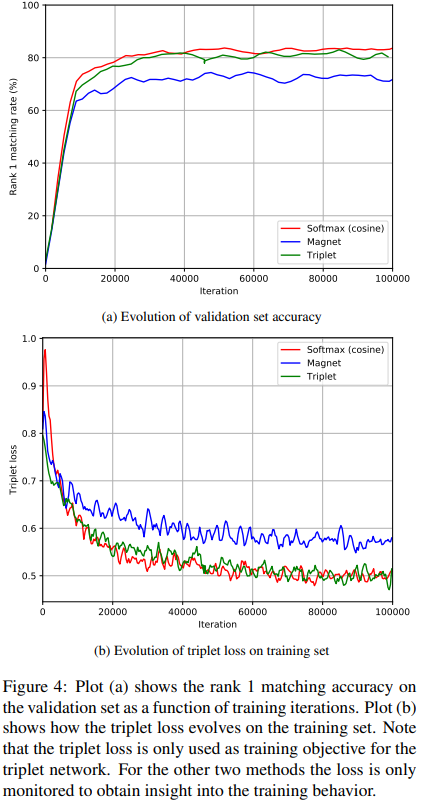

본 섹션에 보고된 결과는 Adam [9]을 사용하여 100,000번의 고정 반복에서 네트워크를 학습하여 얻어졌습니다. 학습률은 $1×10^{−3}$ 로 설정되었습니다. 그림 4에서 볼 수 있듯이 모든 설정이 이 시점에서 완전히 수렴하였습니다. 네트워크는 $1×10^{−8}$ 의 가중치 감소와 잔차(residual) 유닛 내부의 0.4 확률로 드롭아웃을 사용하여 정규화되었습니다. 자석 손실(magnet loss)의 여유는 $m=1$ 로 설정되었고, 코사인 소프트맥스 스케일 $κ$ 는 옵티마이저가 조정할 수 있는 자유 매개변수로 남아 있었지만 $1×10^{−1}$ 의 가중치 감소로 정규화되었습니다. 배치 크기는 128 이미지로 고정되었습니다. 갤러리 순위는 자석 손실 및 삼중 손실의 경우 유클리드 거리를 사용하여 설정되었으며, 소프트맥스 분류기에서는 코사인 유사성이 사용되었습니다. 학습 세트의 변동성을 높이기 위해 입력 이미지는 무작위로 뒤집혔지만, 무작위 크기 조정이나 자르기는 수행되지 않았습니다.

Training Behavior

그림 4a는 MARS 검증 세트에서 반복 횟수에 따른 랭크 1 매칭 비율을 보여줍니다. Market 1501에서 얻어진 결과는 유사한 학습 행동을 보이므로 생략되었습니다. 코사인 소프트맥스 분류기로 학습된 네트워크는 전반적으로 최고의 성능을 달성했으며, 소프트 마진 삼중 손실로 학습된 네트워크가 그 뒤를 이었습니다. 소프트맥스 네트워크의 최고 검증 성능은 49,760번째 반복에서 랭크 1 매칭 비율 84.92%로 도달했습니다. 삼중 손실 네트워크의 최고 성능은 86,329번째 반복에서 랭크 1 매칭 비율 83.23%로 도달했습니다. 자석 손실 네트워크는 47,677번째 반복에서 랭크 1 매칭 비율 77.34%로 최고 성능에 도달했습니다. 전반적으로, 세 손실의 수렴 행동은 유사했지만, 자석 손실은 최종 모델 성능에서 뒤쳐졌습니다. 원래 구현에서는 [19] 같은 클래스가 동일한 배치에 나타나도록 배치를 샘플링했습니다. 그러나 실용적인 이유로 이러한 더 유익한 샘플 마이닝은 구현되지 않았으며, 대신 각 배치에서 개별적으로 고정된 수의 이미지를 무작위로 선택했습니다. 자석 손실은 다른 두 손실보다 덜 유익한 샘플링 전략으로 인해 더 많은 영향을 받았을 가능성이 있습니다.

모든 실행 동안 삼중 손실은 학습 행동에 대한 추가 정보 소스로 모니터링되었습니다. 그림 4b는 반복 횟수에 따른 삼중 손실을 보여줍니다. 삼중 손실은 소프트맥스(코사인) 및 자석 실행에서 학습 목표로 사용되지 않았습니다. 그럼에도 불구하고, 두 손실 모두 간접적으로 삼중 손실을 최소화합니다. 특히 소프트맥스 분류기는 삼중 손실을 최소화하는 데 매우 효율적입니다. 20,000에서 40,000 반복 동안 소프트맥스 분류기로 최적화할 때 삼중 손실은 삼중 손실을 직접 최적화할 때보다 약간 더 빠르게 감소합니다. 따라서 코사인 소프트맥스 분류기는 표현 공간에 유사성 메트릭을 효과적으로 적용합니다.

Re-Identification Performance

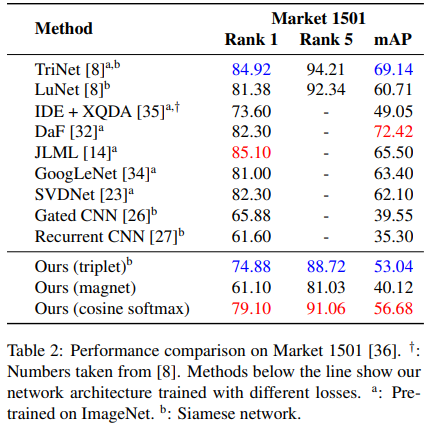

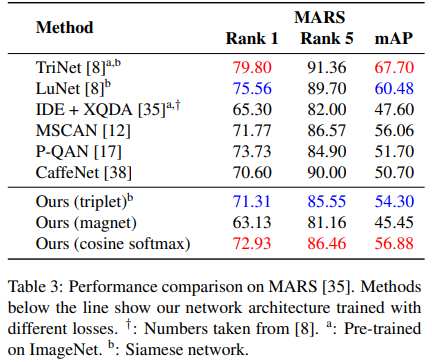

세 네트워크 모두 Market 1501과 MARS 데이터셋의 제공된 테스트 분할에서 평가되었습니다. 표 2와 표 3은 결과를 요약하고 최첨단 기술과 비교를 제공합니다. 검증 세트에서 관찰된 학습 행동과 랭크 1 매칭 비율은 제공된 테스트 분할에서 최종 성능으로 나타납니다. 자체 네트워크 중 코사인 소프트맥스 네트워크는 두 데이터셋 모두에서 가장 우수한 결과를 달성했으며, 그 뒤를 시암 네트워크가 이었습니다. 소프트맥스 손실로 인해 mAP에서의 향상은 Market 1501 데이터셋에서 3.64, MARS 데이터셋에서 2.58로, 각각 6.8%와 4.7%의 상대적 향상입니다. 최첨단 기술은 표 2와 표 3에서 $^b$로 표시된 대조 손실(contrastive loss) 또는 삼중 손실(triplet loss)로 학습된 여러 대안 시암 네트워크를 포함합니다. 이들 네트워크의 성능은 모델 용량이 다양하기 때문에 항상 직접 비교할 수 있는 것은 아닙니다. 그러나 Hermans et al. [8]의 LuNet은 제안된 아키텍처의 약 두 배 용량을 가진 잔차 네트워크입니다. 보고된 숫자는 해당 저자에 따르면 약 3 mAP 포인트에 해당하는 테스트 시간 데이터 증강을 사용하여 생성되었습니다. 따라서, 제안된 네트워크는 훨씬 낮은 용량으로 유사한 범위에 도달합니다. 추가적으로, [35]의 방법은 기존 소프트맥스 분류기로 학습된 CaffeNet을 참조하며, 메트릭 하위 공간은 별도의 후처리 단계에서 얻어졌습니다. 결과는 제안된 공동 분류 및 메트릭 학습 프레임워크가 표현 공간에 메트릭을 적용할 뿐만 아니라, 분류기 내에 메트릭을 직접 인코딩하는 것이 후처리 단계에서 처리하는 것보다 더 효과적임을 시사합니다.

Market 1501에서 가장 성능이 좋은 방법은 코사인 소프트맥스 네트워크보다 mAP 점수가 15.84포인트 더 높습니다. MARS에서 가장 성능이 좋은 방법은 10.82 더 높은 mAP를 달성합니다. 이는 제안된 네트워크에 비해 큰 향상폭으로, 더 큰 용량의 아키텍처와 추가 사전 학습(pre-training)을 적용하여 상당한 향상이 가능함을 보여줍니다. 예를 들어, TriNet [8]은 25.74백만 개의 매개변수를 가진 ResNet-50 [6]으로, ImageNet [11]에서 사전 학습되었습니다. 매개변수 수가 절반 수준인 우리의 네트워크는 용량이 훨씬 낮습니다. 가장 성능이 좋은 네트워크는 ImageNet에서 사전 학습 없이 처음부터 학습되었으며, Hermans et al. [8]의 LuNet과 유사합니다. 약 5백만 개의 매개변수를 가진 이 네트워크는 여전히 약 두 배 크기이지만, 최종 모델 성능은 mAP 기준으로 (테스트 시간 증강 포함) 4.03 및 3.6포인트 더 높습니다. 따라서, 제안된 아키텍처는 계산 효율성과 재식별 성능 사이에서 좋은 균형을 제공합니다.

Learned Embedding

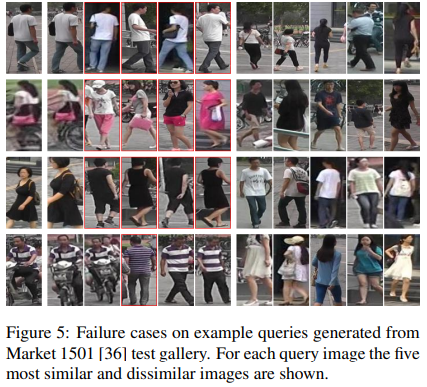

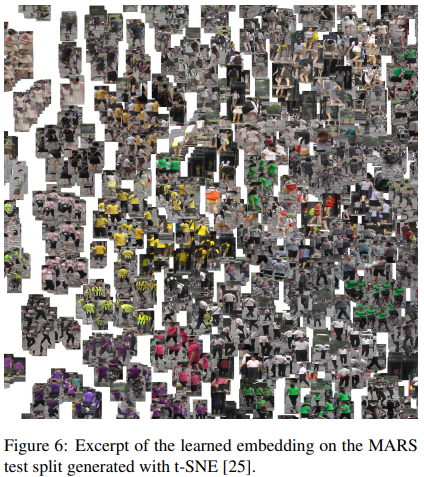

그림 1과 그림 5는 Market 1501 테스트 갤러리에서 계산된 일련의 예제 쿼리를 보여줍니다. 그림 1에 표시된 쿼리는 네트워크가 최근접 이웃 검색을 통해 성공적으로 식별한 여러 정체성 중 일부를 나타냅니다. 많은 경우, 특징 표현은 다양한 자세와 배경 변화, 이미지 품질에 강인합니다. 그림 5는 일부 도전적인 쿼리와 흥미로운 실패 사례를 보여줍니다. 예를 들어, 두 번째 행에서 네트워크는 낮은 해상도의 여성 이미지에서 밝은 핸드백에 초점을 맞추는 것으로 보입니다. 네트워크가 반환한 상위 5개 결과에는 화려한 옷을 입은 네 명의 여성이 포함되어 있습니다. 세 번째 행에서 네트워크는 쿼리된 정체성의 성별을 올바르게 식별하지 못합니다. 마지막 예에서는, 네트워크가 처음에 스쿠터에 앉아 있다가 나중에 걸어가는 사람을 성공적으로 재식별했지만(랭크 4 및 5), 비슷한 줄무늬 스웨터를 입은 잘못된 정체성도 반환합니다(랭크 3). MARS 테스트 분할에서 학습된 임베딩의 시각화는 그림 6에 표시되어 있습니다.

6. Conclusion

우리는 훈련 세트에서 개체를 식별하도록 학습할 때 표현 공간에서 코사인 유사성을 적용하는 기존 소프트맥스 분류기의 재매개화를 제시했습니다. 이 속성 덕분에, 훈련 후 네트워크에서 분류기를 제거하고 미지의 정체성에 대한 쿼리를 최근접 이웃 검색을 사용하여 수행할 수 있습니다. 따라서, 제안된 접근 방식은 정교한 샘플링 전략이 필요하지 않은 메트릭 학습의 간단하고 쉽게 적용 가능한 대안을 제공합니다. 우리의 실험에서, 이 체제에서의 학습은 테스트 성능에서 약간의 향상을 제공했습니다. 방법 자체는 일반적이지만, 우리의 평가는 단일 경량 CNN 아키텍처를 사용하는 매우 특정한 응용 프로그램으로 제한되었습니다. 향후 연구에서는 더 많은 데이터셋과 응용 도메인에서 이 접근 방식을 추가로 검증해야 합니다. 이러한 평가는 더 큰 용량의 아키텍처와 ImageNet에서의 사전 학습도 포함해야 합니다.

Nicolai Wojke, Alex Bewley Deep Cosine Metric Learning for Person Re-Identification

댓글남기기